CNN简介

卷积运算重要思想

- 稀疏表示

- 参数共享

- 等变表示

CNN网络结构

常见层如下:

- 输入层:用于数据的输入

- 卷积层:使用卷积核进行特征提取和特征映射

- 激励层:由于卷积也是一种线性运算,因此需要增加非线性映射

- 池化层:进行下采样,对特征图稀疏处理,减少数据运算量

- 全连接层:通常在CNN的尾部进行重新拟合,减少特征信息的损失

- 输出层:用于输出结果

当然,还可以根据实际需要,增加其他功能层:

- 归一化层:在CNN中对特征的归一化

- 切分层:对某些(图片)数据的进行分区域的单独学习

- 融合层:对独立进行特征学习的分支进行融合

卷积层

卷积层有两个重要概念,local receptive fields和shared weights。 我们将感受视野中的权重矩阵称为卷积核,将感受视野对输入的扫描间隔称为步长,我们将通过一个带有 卷积核 的感受视野扫描生成的下一层神经元矩阵称为一个feature map(特征映射图)。

激励层

激励层主要对卷积层的输出进行一个非线性映射,因为卷积层的计算还是一种线性计算。使用的激励函数一般为ReLu函数:

f(x)=max(x,0)

卷积层和激励层通常合并在一起称为“卷积层”。

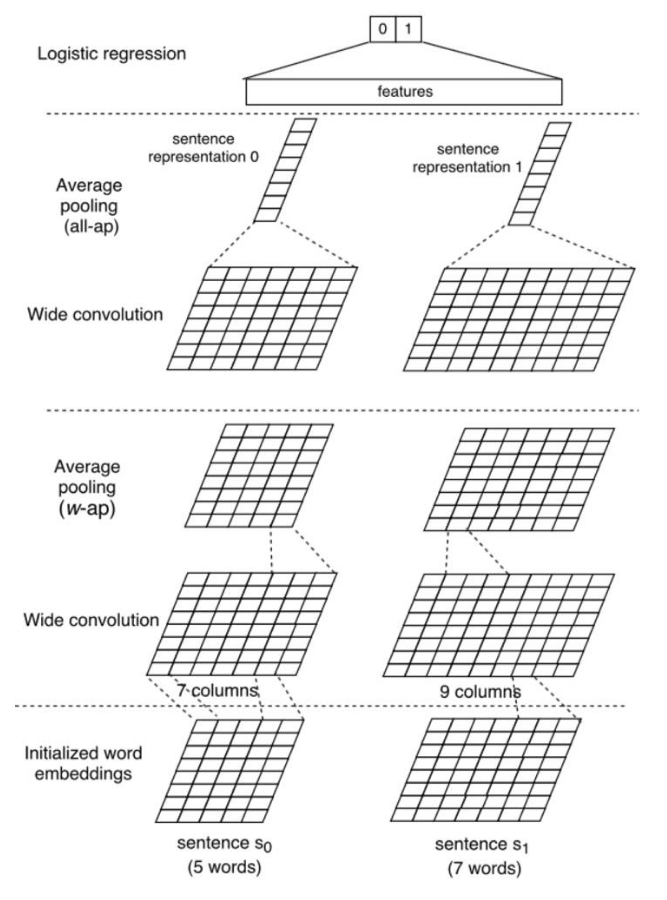

BCNN

参考

- CNN中十个拍案叫绝的操作

- https://zhuanlan.zhihu.com/p/28749411?from=singlemessage

- https://zhuanlan.zhihu.com/p/64693337