目录

概念

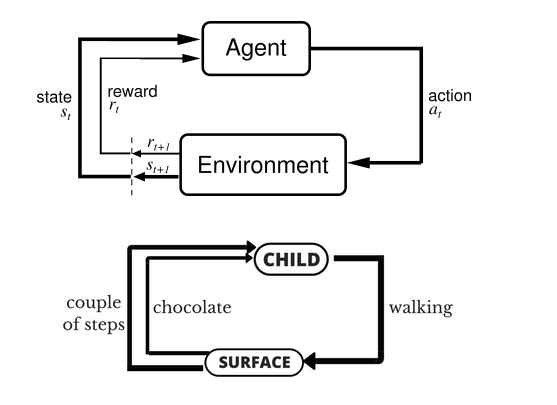

强化学习是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益。其灵感来源于心理学中的行为主义理论,即有机体如何在环境给予的奖励或惩罚的刺激下,逐步形成对刺激的预期,产生能获得最大利益的习惯性行为。

问题建模

马尔可夫决策过程(Markov Decision Process,MDP)是强化学习的最基本理论模型。一般地,MDP可以由一个四元组<S, A, R, T>表示:

- S为状态空间(State Space);

- A为动作空间(Action Space);

- R为奖赏函数;

- T为环境状态转移函数(State Transition Function)

图形化表示

千言不如一图:

与其他机器学习算法区别

- There is no supervisor, only a reward signal

- Feedback is delayed, not instantaneous

- Time really matters (sequential, non i.i.d data)

- Agent’s actions affect the subsequent data it receives

Reward Hypothesis

All goals can be described by the maximisation of expected cumulative reward.

Policy Gradient

几类方法

- Policy based:找最优策略

- Value based:找最优奖励

- Action based:每一步最优行动

参考

-

http://www.cs.ucl.ac.uk/staff/D.Silver/web/Teaching.html