目录

简介

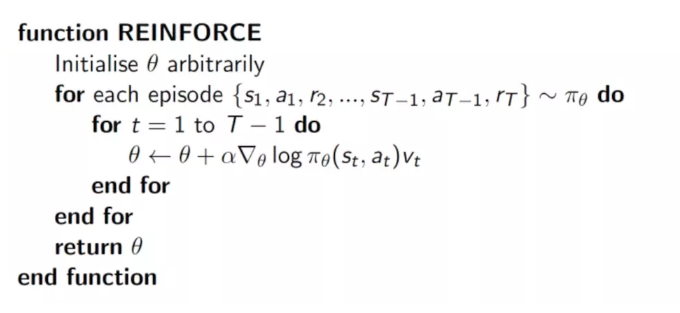

策略梯度的基本思想,就是直接根据状态输出动作或者动作的概率。

如果一个动作得到的reward多,那么我们就使其出现的概率增加,如果一个动作得到的reward少,我们就使其出现的概率减小。

根据这个思想,我们构造如下的损失函数:loss= -log(prob)*vt

策略梯度算法必须要完成一个完整的eposide才可以进行参数更新,而不是像值方法那样,每一个(s,a,r,s')都可以进行参数更新。

Policy Gradient的核心思想是更新参数时有两个考虑:如果这个回合选择某一动作,下一回合选择该动作的概率大一些,然后再看奖惩值,如果奖惩是正的,那么会放大这个动作的概率,如果奖惩是负的,就会减小该动作的概率。

过程

细节

- 算法输出的是动作的概率,而不是Q值。

- 损失函数的形式为:loss= -log(prob)*vt

- 需要一次完整的episode才可以进行参数的更新