[2502.05558] Large Memory Network for Recommendation

《Large Memory Network for Recommendation》提出了大型记忆网络(LMN),旨在解决推荐系统中用户行为序列建模的挑战,通过构建大规模内存块来压缩和存储用户历史行为信息,在离线和在线实验中均展现出优越性能,目前已在抖音电商搜索中全面部署。

-

引言:用户行为序列对理解用户偏好意义重大。现有序列建模方法存在问题,如基于目标注意力机制的方法适用于短序列,基于搜索机制的模型部署复杂且兴趣估计不完整,直接对长序列建模会增加计算成本。虽然扩大模型参数在一些领域有成效,但在推荐系统中简单缩放参数会降低效率。内存网络结构可增强模型能力,不过现有内存机制在推荐领域应用较少且存在不足。因此,本文提出LMN,有效压缩用户序列,实现模型参数扩展,同时建立用户间空间感知和长期兴趣记忆,推动推荐系统发展。

-

方法

- 问题公式化:聚焦推荐系统中的点击率(CTR)预测任务,整体学习目标是通过用户、物品、用户 - 物品交叉特征嵌入以及用户序列表示,由推荐模型预测CTR。

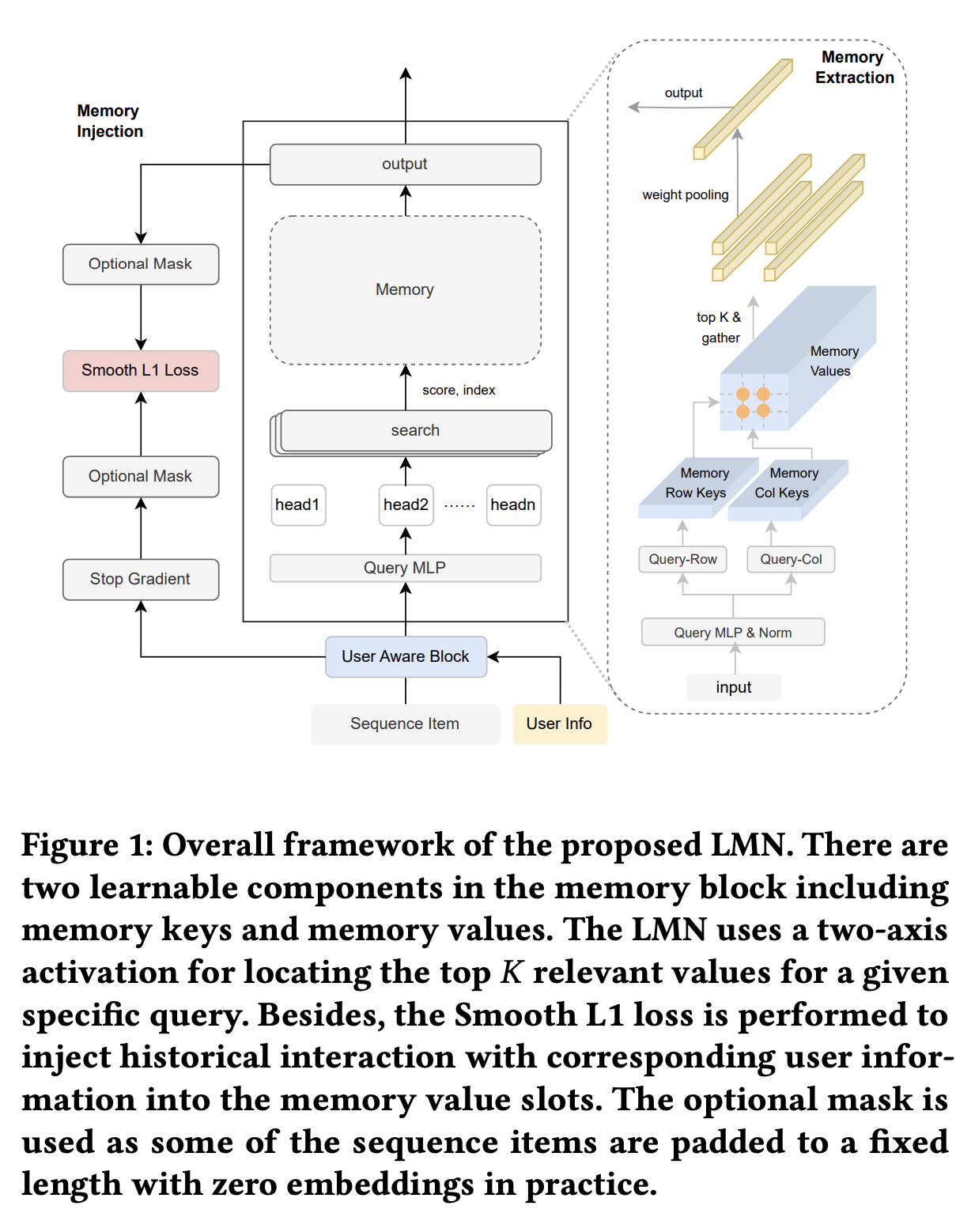

- LMN模型:由内存提取和内存注入两个阶段构成。内存提取阶段,基于乘积量化设计内存激活机制,引入用户感知模块优化查询;内存注入阶段,采用基于Smooth - L1的内存损失将用户 - 物品对信息注入内存槽。

- 模型训练和部署:LMN可作为即插即用模块融入现有CTR预测模型,通过平衡参数整合任务损失和内存损失。在线部署时,引入内存参数服务器,采用GPU分片策略在多GPU的高带宽内存上分布式存储内存值,确保高效训练和服务。

-

实验

- 评估设置:在抖音电商搜索场景进行实验,收集相关流量日志,选取多种方法对比,采用AUC、LogLoss指标评估模型性能,并引入相对改进指标衡量AUC增益。

- 实验结果:序列建模对推荐意义重大,LMN在AUC和LogLoss指标上表现突出,相比其他方法有显著提升。增加内存键数量能持续提高模型性能。

- 在线A/B实验:在线A/B测试显示,部署LMN后,关键商业指标显著提升,且在线服务延迟仅轻微增加,证明了部署框架的效率。

-

结论:LMN通过大规模内存块有效压缩和记忆用户兴趣,实现空间感知和时间记忆。本文还提出可进一步探索记忆推荐模型中的其他重要信息,以提升推荐效果,为推荐系统发展提供新方向。